1️⃣ 什么是 LLM?(不要从 Transformer 细节讲)

🎯 目标

建立正确的“心智模型”,而不是算法细节。

PPT 重点

LLM ≠ 搜索引擎

LLM ≠ 知识库

LLM 是:

基于上下文进行概率建模的语言生成器

推荐一句话定义

LLM = 一个根据“上下文”预测下一个 token 的函数

可以用的类比

自动补全(IDE)

超级“上下文敏感”的

String -> String函数

1️⃣ 《Prompt Engineering Guide》

网站

优点:

从 0 到进阶

有大量可复现示例

对“为什么有效”讲得清楚

2️⃣ OpenAI Cookbook(通用思想,不限 OpenAI)

Andrej Karpathy:LLM from Zero to Hero

不讲 API

讲“模型如何思考”

极其适合建立直觉

案例:

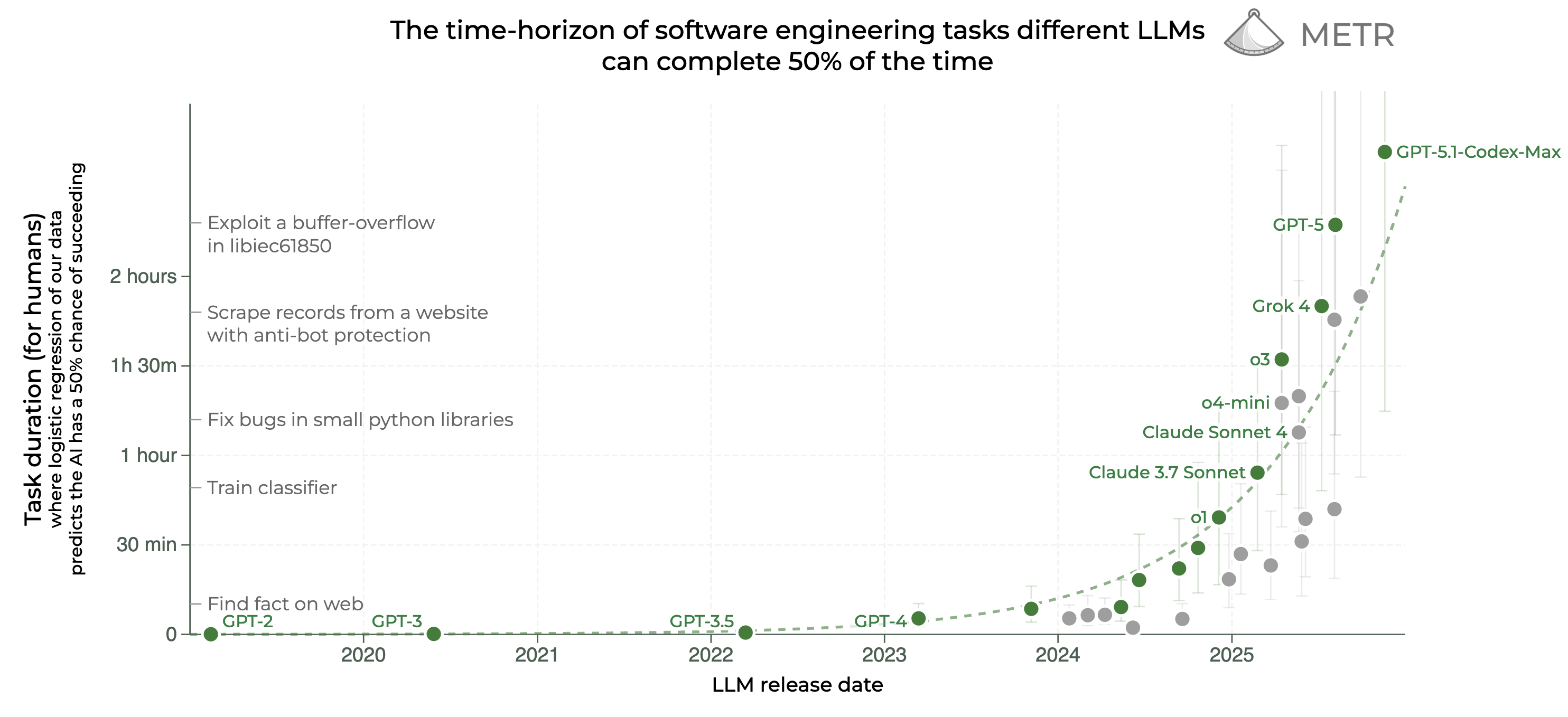

Simon Willison(Django 框架的联合创始人)。他一边陪家人装饰圣诞树、看电影,一边用 Codex CLI + GPT-5.2,把 Emil Stenström 的 JustHTML(纯 Python、通过 html5lib-tests)迁移成了一个纯 JS、零依赖的库,跑过了 9200+ 个 html5lib-tests 用例,最终产出大约 9000 行代码、43 次提交。

前端已死?前端不死,只是工作模式升级。https://daydream.site/shared/306

提示词技巧:

3. 防止“加戏”:避免过度设计

Opus 4.5 有时候会有点“想太多”,导致过度设计 (Overengineer,即把简单问题复杂化),比如凭空增加不必要的文件或者搞一堆复杂的抽象层。

要解决这个问题,你得在提示词里把话说明白,比如加上:“Only make changes that are directly requested. Keep solutions simple and focused.”(只修改我明确要求的部分。保持解决方案简洁、聚焦。)

Agent

最近我也在按照这个思路设计agent,核心的思想是:把Agent想象成一个每次工作前都会失忆的资深软件工程师,他需要像《未知死亡》里的男主那样,每次都靠笔记来回忆自己要做什么。这样设计agent,有多个好处,比如节省token,比如人类可以使用相同的文档快速了解项目和上手,大模型比较专注,不容易出错

AI Agent 也不是魔法,它一样需要从人类软件工程中汲取经验,它也需要将复杂的任务进行分解成简单的任务,要有一个结构化的工作环境和清晰的交接机制。

以现在模型的能力,Coding Agent 已经能做很多事情了,核心还是在于你是不是能像软件工程中那样,去分解好任务,设计好工作的流程。

https://daydream.site/shared/303

技巧

Andrej Karpathy 最新的一条推文(x.com/karpathy/status/1997731268969304070)建议你跟LLM(大语言模型)对话时,少用“你”怎么看,而是先问问这个领域的专家都是谁,然后让 AI 模拟这个领域的专家回答问题,这样能得到更好的效果。

“关于 xyz,你怎么看?”

因为根本就不存在什么“你”。

下次试试换个问法:

“如果要探讨 xyz 这个话题,最合适的一群人(比如专家或利益相关者)会是谁?他们会说些什么?”

大语言模型可以信手拈来地引导和模拟各种各样的视角。但它并不像我们人类那样,是经过长时间对 xyz 的“思考”和沉淀,才形成自己的观点的。

如果你非要用“你”这个词去强行提问,模型就会被迫根据它 微调 (finetuning) 数据的统计规律,调用一种隐含的“人格嵌入向量 (personality embedding vector)”,然后扮演这种人格来给你模拟一个答案。 (注释:简单来说,当你问“你”时,AI 只是根据训练数据中最常见的回答模式,戴上了一个“大众脸”的面具来配合你,而不是它真的产生了一个拥有自我意识的人格。)

这样做当然没问题,你也能得到答案。但我发现很多人天真地把这归结为“去问问 AI 怎么想”,觉得这事儿特玄乎。其实一旦你明白了它是如何模拟的,这层神秘的面纱也就被揭开了。

技巧

架构先行:人先搭好架子,再让AI来填空。

先规划再写代码

AI 编程工具就像杠杆,放大你的能力也放大你的缺陷。如果你本来就知道自己在做什么,它让你如虎添翼。如果你本来就不知道自己在做什么,它让你更高效地挖坑。